Intel propose plus de 500 modèles d'IA optimisés sur les processeurs Core Ultra

Qu’est-ce qu’une « IA » ? En termes simples, la façon dont nous utilisons le terme « IA » de nos jours est un peu trompeuse. Il décrit principalement les réseaux de neurones, des boîtes fonctionnellement noires dans lesquelles vous insérez des données, puis d'autres données en sortent, insérées (espérons-le) comme vous le souhaitez. Cependant, les réseaux de neurones ne sont pas des programmes ; ils ne sont pas exécutables. Vous ne pouvez pas simplement cliquer sur un point de contrôle et l'exécuter comme n'importe quelle autre application. Ils s’appuient sur une variété de frameworks pour configurer et traiter les données.

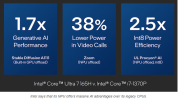

Jusqu'à relativement récemment, la plupart de ces frameworks ciblaient l'API CUDA de NVIDIA et son matériel GPU. Cependant, grâce aux efforts de la communauté open source ainsi que des développeurs travaillant pour Intel, AMD et d'autres sociétés, un grand nombre de ces frameworks peuvent être exécutés sur à peu près n'importe quel matériel de votre choix. En effet, c'est le sujet d'un communiqué qu'Intel vient de publier intitulé "Plus de 500 modèles d'IA exécutés de manière optimisée sur les processeurs Intel Core Ultra".Le titre raconte assez bien l'histoire : il existe des centaines de modèles d'IA prêts à être déployés avec de bonnes performances sur les processeurs Intel Core Ultra. Ces puces disposent d'une accélération du traitement de l'IA sous la forme d'instructions CPU spécialisées, d'un puissant GPU Arc intégré et, bien sûr, d'un NPU dédié, ou unité de traitement neuronal. Vous pouvez pratiquement utiliser l'une de ces trois parties d'un processeur Core Ultra, ou une combinaison de celles-ci, pour obtenir de solides performances pour les tâches de traitement de l'IA, bien que celle que vous souhaitez cibler dépende de vos besoins exacts et du modèle d'IA en cours. employé.

Intel considère OpenVINO, PyTorch, ONNX et le référentiel de modèles Hugging Face comme cibles valides pour exécuter l'IA sur son matériel. En effet, ces quatre cibles constituent la grande majorité de l’IA hébergée localement disponible aujourd’hui. Avec la prise en charge de ces quatre éléments (et il y en a bien plus), vous pouvez héberger et exécuter toutes sortes de modèles d'IA, y compris de grands modèles de langage, des diffuseurs et upscalers d'images, la détection d'objets et la vision par ordinateur, la classification d'images, les moteurs de recommandation, etc. Bien sûr, Chipzilla dispose de beaucoup plus de matériel compatible IA que les processeurs Core Ultra, mais le fait est que vous n'avez pas besoin de cibler des GPU discrets si vous souhaitez exécuter l'IA sur des systèmes clients. Intel veut s'assurer que le message soit passé : l'IA est démocratisée et elle peut fonctionner à peu près partout où vous le souhaitez à ce stade. Assurez-vous simplement que votre système cible dispose de suffisamment de RAM et vous êtes probablement prêt à partir.

HOTHARDWARE